AI-LAB 인공지능 실습 2강 머신러닝(Machine Learning)

이번 시간에는 머신러닝에 대해 공부하는 시간입니다. 머신러닝의 역사를 간략하게 알아보겠습니다.

Arthru Samuel (1959): Machine Learning is a field of study that gives computers the ability to learn without being explicitly programmed

1950년대에 체커 게임을 개발했던 Arthur Samuel은 명시적으로 "프로그램이 작성되지 않아도 컴퓨터가 스스로 학습할 수 있는 능력을 제공하는 학문"을 기계학습이라고 정의하였습니다. 체커 게임을 만든 Arthur Samuel은 사실 체커게임을 잘 두지 못했지만 그가 해낸 것은 그의 컴퓨터로 하여금 수많은 게임을 통하여 어느 위치에 있으면 이기는 경우가 많아지는 지를 분석하였고 이기는 방법을 스스로 학습하게 하였으며 마침내 Arthur Samuel도 이길 수 없는 수준의 강자가 되어버렸습니다. 하지만 위의 정의는 너무 모호하고 오래된 것이기에 머신러닝의 대가 톰 미첼(Tom Mitchell)이 정의한 머신러닝(Machine Learning)에 대해서 알아봅시다.

Tom Mitchell (1988): A computer program is said to learn from experience E with respect to some task T and some performance measure P, if its performance on t, as measured by P, improves with experience E

머신러닝의 대가 Tom Mitchell은 "컴퓨터가 어떤 작업(T)를 하는데 있어서 경험(E)로부터 학습하여 성능에 대한 측정(P)를 향상시키는 학문"을 기계학습이라고 정의하였습니다. 체커 게임을 예시로 경험(E)는 수많은 체커 게임을 하는 것이고, 작업(T)는 체커 게임을 하는 일이며, 성능 측정(P)는 다음 체커 게임에서 이길 확룔이 됩니다. 컴퓨터는 체커게임에서 수많은 게임(T)을 통해서 경험(E)으로부터 승리할 확률(P)을 향상시켰기에 기계학습에 대한 대표적인 예시가 됩니다.

예를 들어 우리의 이메일 프로그램이 우리가 스팸으로 지정한 메일들에 대해서 기계학습을 하여 스팸메일을 더 잘 필터링하는 것을 학습한다고 할 때, 여기서 작업(T)는 무엇이 될까요? 바로 이메일들을 스팸인지 아닌지 분류하는 것입니다. 사용자가 스팸인지 아닌지 분류한 이메일들을 검사하는 것은 경험(E)가 되고 올바르게 분류된 메일의 수는 성능 측정(P)가 될 것입니다.

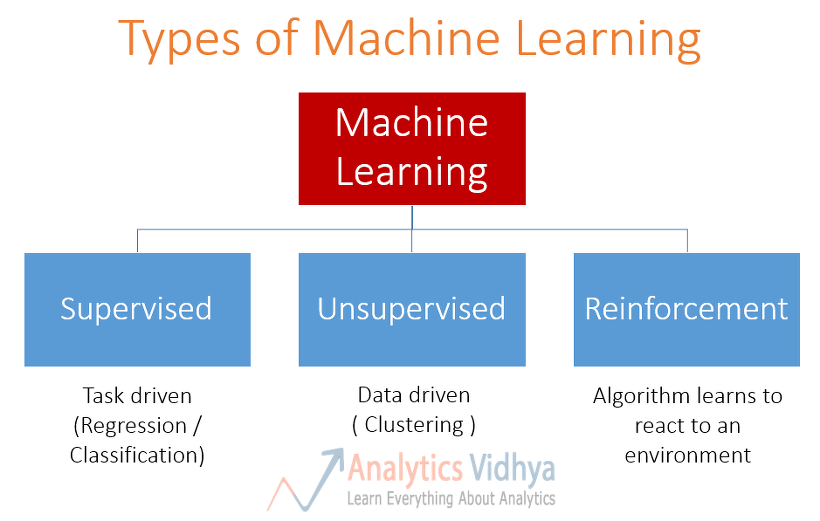

[머신러닝 알고리즘(Machine Learning Algorithms)]

• 지도 학습(Supervised Learning)

• 비지도 학습(Unsupervised Learning)

• 강화 학습(Reinforcement Learning)

• 추천 시스템(Recommender System)

기계학습으로 문제를 해결하는 방법은 크게 2가지로 나누어집니다. 지도 학습(Supervised Learning)은 개발자가 컴퓨터에게 무엇인가를 수행하라고 학습시키는 반면 비지도 학습(Unsupervised Learning)은 컴퓨터가 스스로 학습하게 합니다. 그 외에도 강화 학습(Reinforcement Learning), 추천 시스템(Recommender System) 등이 있는데 이번 장에서는 개요에 대해서만 짚으므로 다음 장에서 2개의 학습 방법에 대해서 자세히 얘기하도록 하겠습니다.

참고문서

'개발자 > 인공지능과 인간' 카테고리의 다른 글

| 일본, AI 특화 슈퍼컴퓨터 개발 통해세계 1위 탈환 (0) | 2020.09.03 |

|---|---|

| 美 AI4K12 이니셔티브,초중등 AI 교육 가이드라인 업데이트 (0) | 2020.08.31 |

| AI-LAB 인공지능 실습 3강 머신러닝 지도학습(Supervised Learning) , 비지도학습(Unsupervised Learning) (0) | 2020.08.28 |

| OpenAI, 자연어 처리를 위한 범용 API 공개 (0) | 2020.08.27 |

| AI-LAB 인공지능 실습 1강 인공지능 개요 (0) | 2020.08.26 |

| AI 주도 기업들 안면인식 AI 개발 및 공급 중단 발표 (0) | 2020.08.26 |

| AI 기술의 한계에 대한 냉정한 인식 필요 (0) | 2020.08.25 |

| 도커 Docker 기본적인 이해 (2) | 2020.08.07 |

취업, 창업의 막막함, 외주 관리, 제품 부재!

당신의 고민은 무엇입니까? 현실과 동떨어진 교육, 실패만 반복하는 외주 계약,

아이디어는 있지만 구현할 기술이 없는 막막함.

우리는 알고 있습니다. 문제의 원인은 '명확한 학습, 실전 경험과 신뢰할 수 있는 기술력의 부재'에서 시작됩니다.

이제 고민을 멈추고, 캐어랩을 만나세요!

코딩(펌웨어), 전자부품과 디지털 회로설계, PCB 설계 제작, 고객(시장/수출) 발굴과 마케팅 전략으로 당신을 지원합니다.

제품 설계의 고수는 성공이 만든 게 아니라 실패가 만듭니다. 아이디어를 양산 가능한 제품으로!

귀사의 제품을 만드세요. 교육과 개발 실적으로 신뢰할 수 있는 파트너를 확보하세요.

지난 30년 여정, 캐어랩이 얻은 모든 것을 함께 나누고 싶습니다.

귀사가 성공하기까지의 긴 고난의 시간을 캐어랩과 함께 하세요.

캐어랩