Ollama를 사용하여 Raspberry Pi에서 ChatGPT를 로컬로 실행하는 방법

ChatGPT 같은 AI와 대화하는 것은 이제 우리 일상에 익숙해졌지만, 대화량 제한에 부딪히거나 AI 기업에 개인 정보를 모두 제공해야 하는 상황은 꽤나 불편합니다. 라즈베리 파이에서 AI 챗봇을 로컬로 실행하면 이러한 문제를 해결할 수 있을까요? 네, 가능합니다. 이 글에서는 몇 가지 간단한 단계를 통해 설치 방법을 안내해 드리겠습니다.

AI 챗봇은 라즈베리 파이에서 자체 호스팅할 수 있습니다. 라즈베리 파이에서 대규모 언어 모델(LLM)을 실행하는 것은 무료이며 사용량 제한이 없고 다양한 사용 사례에 맞게 조정할 수 있습니다. Ollama를 사용하여 웹 UI 채팅 인터페이스와 함께 설치할 수 있습니다.

먼저, 왜 이런 작업을 해야 하는지 간략하게 살펴보겠습니다. 또한 모든 것을 설치하는 방법과 라즈베리 파이에서 특히 잘 작동하는 AI 모델에 대한 조언도 드리겠습니다.

목차

- 개요: 라즈베리 파이에 AI 모델을 호스팅해야 하는 이유는 무엇일까요?

- Raspberry Pi에서 Ollama를 사용하기 위한 하드웨어 요구 사항

- 라즈베리 파이에 Ollama 설치하기

- Ollama 시작하기

- 더 나아가기

개요: 라즈베리 파이에 AI 모델을 호스팅해야 하는 이유는 무엇일까요?

여러분은 아마 웹 브라우저나 모바일 앱을 통해 ChatGPT, Claude, Grok 같은 AI 챗봇을 사용하고 있을 겁니다. 이러한 AI 챗봇들은 막대한 컴퓨팅 자원을 보유한 데이터 센터에서 운영됩니다. 예를 들어 "아프리카 제비의 평균 크기는 얼마인가요?"라고 질문하면, ChatGPT는 이러한 자원을 활용하여 신속하게 답을 찾아 답변해 줍니다.

하지만 이러한 AI 모델에 접근하는 다른 방법도 있습니다. 한 가지 방법은 ChatGPT API에 연결하는 스크립트를 사용하는 것이고, 또 다른 방법은 AI 모델을 사용자의 컴퓨터에서 직접 실행하는 것입니다(이 튜토리얼에서 다룰 내용입니다).

짐작하셨겠지만, 이 방법은 온라인 앱을 사용하는 것만큼 강력하거나 빠르지는 않을 겁니다. 설치 단계로 넘어가기 전에 왜 이 방법을 사용해야 하는지 간단히 설명드리겠습니다.

ChatGPT API 사용 시 차이점

참고로, 자체 AI 챗봇을 로컬에서 호스팅하는 것은 ChatGPT API를 사용하는 것과는 다릅니다. API는 코드나 스크립트를 작성하여 ChatGPT(또는 다른 AI 모델)에 접근하는 방법입니다. 또한 일반적으로 API 이용에는 비용이 발생하며, 비용은 선택하는 모델과 사용량에 따라 다릅니다.

해당 접근 방식에 관심이 있으시다면, 저희가 이미 작성한 가이드(여기: 모든 라즈베리 파이 프로젝트에서 ChatGPT API 사용하기)를 참고하세요 .

이 글에서 다루는 내용은 좀 다릅니다. 바로 라즈베리 파이에서 AI 모델을 실행하는 것입니다 . 이 접근 방식에는 장단점이 있는데, 다음에서 간략하게 살펴보겠습니다.

AI 모델을 로컬에서 실행할 때의 이점

- 다음은 AI 모델을 자체 호스팅하는 것이 매력적인 몇 가지 이유입니다.

- 비용 – 사용 제한 없이 무료입니다. 토큰 사용 제한이나 월 구독료가 있는 것보다 훨씬 낫습니다.

- 로컬 추론 – AI 프로젝트는 인터넷 연결 없이 완전히 로컬에서 실행될 수 있습니다.

- 개인정보 보호 – ChatGPT에게 당신의 얼굴을 그려달라고 하거나 사는 곳을 알려달라고 요청해 본 적이 있나요? 수집하는 데이터 양에 따라 놀라울 정도로 정확하게 예측할 수 있습니다. AI 모델을 직접 호스팅하면 데이터에 대한 통제권을 확보할 수 있습니다.

- 보안 – 개인 데이터나 고객 정보와 같은 민감한 정보를 AI에 입력하는 등의 작업을 수행하려면 해당 데이터를 인터넷을 통해 전송하는 것보다 로컬에 저장하는 것이 더 안전합니다.

- 다양한 모델 간 전환 – 다양한 AI 모델을 다운로드하고 각기 다른 강점을 가진 모델들을 전환하며 자신에게 가장 잘 맞는 모델을 찾을 수 있습니다.

- 사용자 친화적인 인터페이스 – API를 사용하는 것과는 달리 프로그래밍 지식이 필요하지 않습니다.

- 맞춤 설정 – 특정 사용 사례에 맞게 모델을 통합하세요.

AI 모델을 로컬에서 실행할 때의 한계점

네, 이론상으로는 모두 훌륭해 보이지만, 현실적으로 라즈베리 파이에서 AI 모델을 실행하는 데에는 분명한 한계가 있습니다.

- 성능 – 자체 호스팅 모델은 온라인 앱에서 얻을 수 있는 응답 속도에 비해 라즈베리 파이 하드웨어에서 더 느리게 작동합니다.

- 컨텍스트 제한 – 라즈베리 파이에서 잘 작동하는 모델은 컨텍스트 제한이 낮습니다. 즉, 대화 내용을 기억하는 데 한계가 있다는 뜻입니다. 예를 들어 전체 프로그램을 수정하거나 책의 여러 장을 요약하는 경우처럼 말이죠. 제가 라즈베리 파이에 설치한 모델 중 하나는 128,000개의 토큰만 처리할 수 있는 반면, 앱을 통해 접근할 수 있는 모델은 200,000개 이상의 토큰을 처리할 수 있는 큰 컨텍스트 창을 가지고 있습니다.

- 모델 복잡성 – 라즈베리 파이의 RAM으로는 특정 매개변수 크기까지만 AI 모델을 실행할 수 있는 반면, ChatGPT나 Grok과 같은 온라인 도구는 훨씬 더 많은 매개변수를 가진 모델에 접근할 수 있어 더 복잡한 질문을 이해할 수 있습니다.

Raspberry Pi에서 Ollama를 사용하기 위한 하드웨어 요구 사항

라즈베리 파이를 처음 시작하는 데 실제로 드는 비용은 얼마일까요?

이 가이드를 따라하기 위해 다음과 같은 하드웨어를 권장합니다.

- 라즈베리 파이 : 여기서는 최대한의 연산 능력이 필요하기 때문에 라즈베리 파이 5가 가장 적합합니다. 학습 실험 목적으로 라즈베리 파이 4를 사용해 볼 수도 있지만, 속도가 상당히 느릴 수 있다는 점을 유의하세요.

- 메모리 : 최소 4GB, 권장 8GB. 메인보드의 RAM 용량에 따라 로드할 수 있는 모델의 복잡성이나 동시에 로드할 수 있는 모델의 수가 결정됩니다.

- 저장 공간 : 32GB의 디스크 공간이면 다양한 모델을 다운로드하고 사용해 볼 수 있습니다. 가능하면 응답 속도를 향상시키기 위해 외장 USB SSD 나 내장 NVMe SSD 와 같은 빠른 저장 장치를 사용하는 것을 권장합니다 .

하드웨어에 대해서는 여기까지 살펴보았지만, 소프트웨어는 어떨까요? 다음 섹션에서 소프트웨어 부분을 다루겠습니다.

라즈베리 파이에 Ollama 설치하기

이제 하드웨어가 준비되었으니 라즈베리 파이에서 AI 모델을 실행할 수 있습니다.

다음은 전체적인 단계별 개요입니다.

- 64비트 운영체제를 설치하세요.

- AI 모델을 불러오려면 Ollama를 설치하세요.

- 사용자 친화적인 채팅 인터페이스를 사용하려면 Open WebUI를 설치하세요.

이제 각 단계를 자세히 살펴보겠습니다.

운영체제 설치

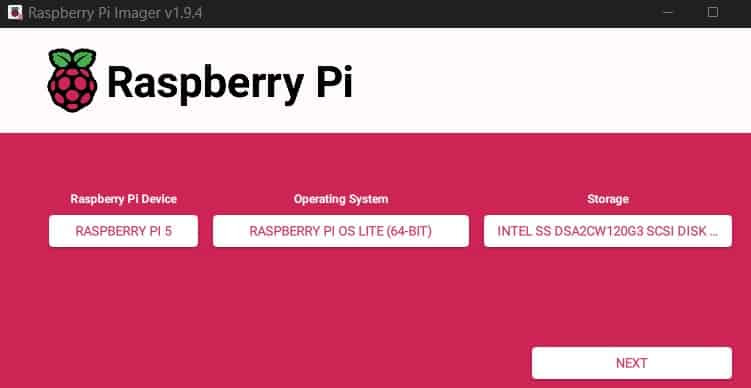

라즈베리 파이 이미지 플래싱 라즈베리 파이 OS 라이트

첫 번째 단계는 64비트 운영 체제를 설치하는 것입니다 . 라즈베리 파이에서 AI 모델을 실행하는 것은 상당한 리소스를 소모하므로, 리소스를 절약하기 위해 가벼운 운영 체제부터 시작하는 것이 좋습니다.

이 튜토리얼에서는 데스크톱 환경이 없는 최소한의 버전인 Raspberry Pi OS Lite를 설치했습니다. 저희 가이드를 따라 똑같이 설치하실 수도 있습니다. 하지만 Ubuntu Server 나 DietPi 와 같은 다른 가벼운 옵션도 괜찮습니다 .

(선택 사항: 저처럼 다른 PC에서 설치 단계를 진행하려면 설치 중에 SSH를 활성화하세요 .)

시스템이 실행되면 시스템을 업데이트하세요.

sudo apt update

sudo apt upgrade

재시작:

sudo reboot

기본 시스템은 설명드렸고, 이제 핵심 소프트웨어에 대해 이야기해 보겠습니다.

Ollama 설치 중

다음 단계는 Ollama를 설치하는 것입니다. Ollama는 AI 모델을 호스팅하는 소프트웨어입니다.

터미널을 열고 명령어 하나만 입력하면 됩니다. 공식 Ollama 설치 스크립트를 실행하세요.

sudo curl -fsSL https://ollama.com/install.sh | sh

참고 : 이 글을 작성할 당시, 이 스크립트가 라즈베리 파이에서 충돌하는 버그가 있었습니다. 이전 HTTP 1.1 표준을 사용하도록 플래그를 추가하면 이 문제를 해결할 수 있습니다.

sudo curl -fsSL --http1.1 https://ollama.com/install.sh | sh

이 스크립트는 Ollama를 다운로드하고 설치한 다음 진행 상황을 알려줍니다.

터미널 스크립트를 사용하여 Ollama를 설치하세요.

(AI는 GPU 하드웨어에서 더 나은 성능을 보이지만, 위의 마지막 줄에서 볼 수 있듯이 Ollama는 Raspberry Pi의 GPU를 사용하도록 프로그래밍되어 있지 않으므로 CPU만 사용합니다.)

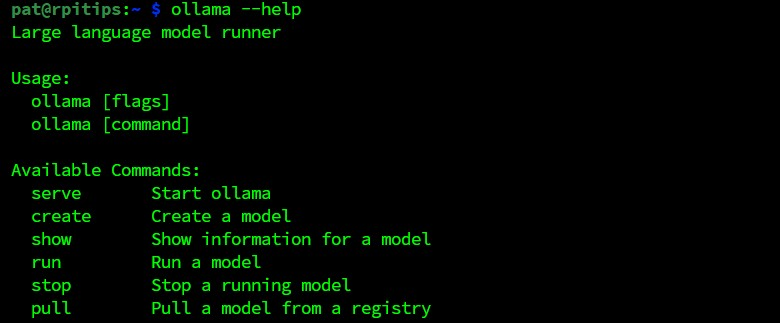

스크립트 실행이 완료되면 ollama 명령어를 사용하여 프로그램을 호출할 수 있습니다.

올라마 명령줄 옵션

이제부터 모든 작업을 명령줄에서 처리할 수도 있습니다. 하지만 우리는 웹 브라우저를 통해 AI와 대화하는 데 더 익숙할 테니, 다음으로 GUI 모듈을 설치해 보겠습니다 .

WebUI 설치 중

올라마 웹UI 채팅 인터페이스

마지막 단계는 Open WebUI를 설치하는 것입니다 .

WebUI는 Ollama를 위한 사용자 친화적인 채팅 인터페이스를 제공합니다.

라즈베리 파이 하드웨어에 WebUI를 더 쉽게 설치하기 위해 Docker를 사용하여 컨테이너로 실행할 것입니다. ( Docker에 대한 자세한 내용은 여기를 참조하세요 .)

Docker를 설치하세요:

sudo apt install docker.io

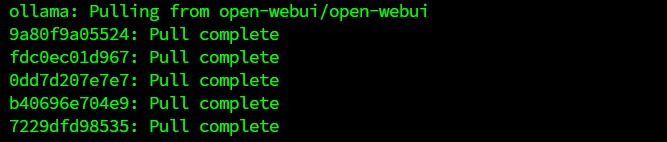

WebUI 컨테이너 이미지를 로드합니다.

sudo docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

ollama webui 도커 설치

이 Docker 명령어는 WebUI를 다운로드한 다음 백그라운드에서 서버로 실행합니다.

축하합니다! 설치 과정이 완료되었습니다. 다음 섹션에서는 사용 방법을 알려드리겠습니다.

Ollama 시작하기

이제 Ollama와 WebUI를 설치했으니, 실제로 AI와 어떻게 대화할까요?

이 섹션에서는 다음 방법을 배우게 됩니다.

- 웹 인터페이스에 접속하세요.

- AI 모델을 선택하고 불러오세요.

- AI와 채팅하세요.

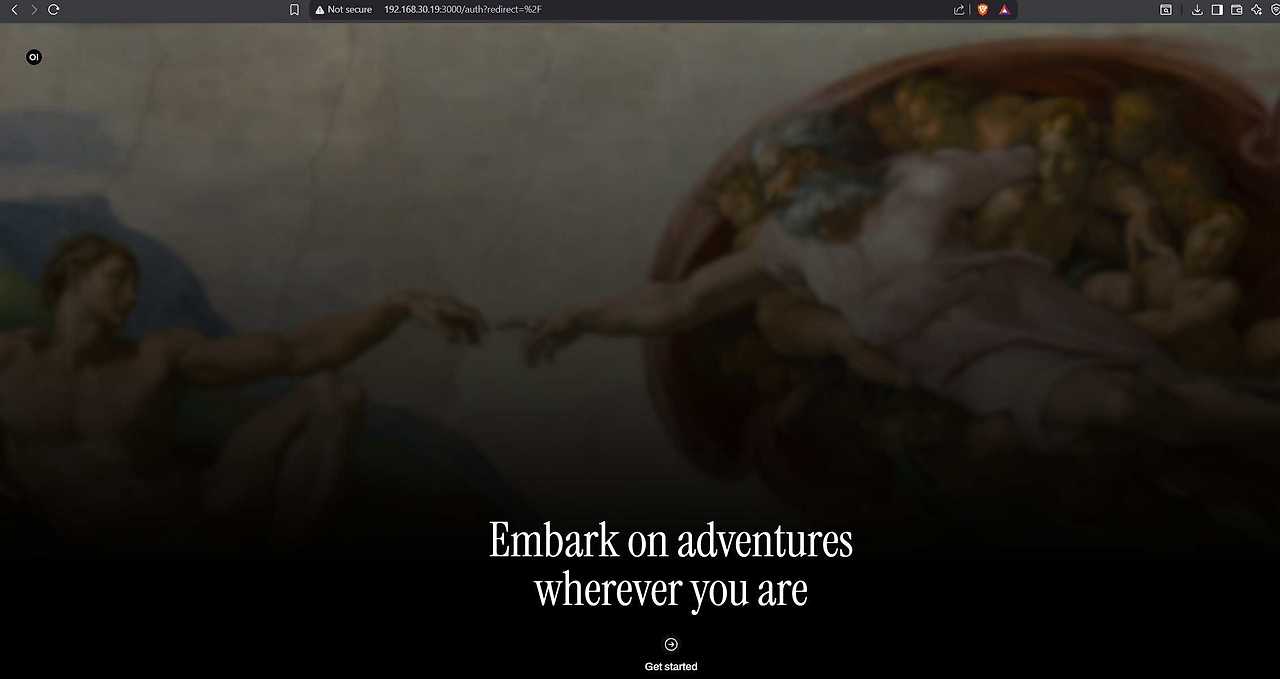

웹 인터페이스 접속

먼저 네트워크에 연결된 다른 PC나 모바일 기기에서 웹 인터페이스에 접속해 보겠습니다. 라즈베리 파이 자체에서도 접속할 수 있습니다.

웹 브라우저에서 라즈베리 파이의 IP 주소 와 3000번 포트로 접속하세요. 예를 들면 다음과 같습니다.

https://192.168.1.100:3000

IP 주소를 찾는 방법을 모르신다면, 저희 가이드 " 라즈베리 파이 IP 주소를 쉽게 찾는 7가지 방법"을 참고하세요 .

저는 몇 번 시도 끝에 겨우 나왔으니, 시간이 좀 걸릴 수도 있어요.

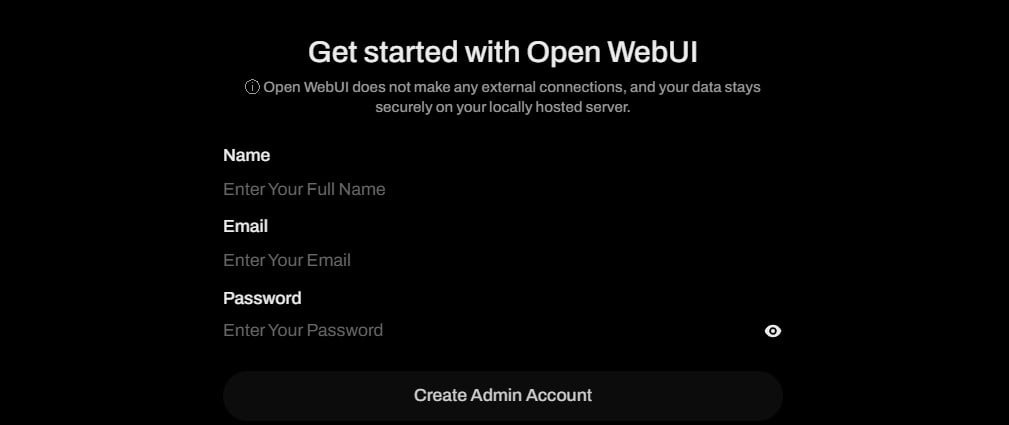

올라마 웹 UI 환영 화면

하단의 "시작하기"를 클릭하세요. 로컬 사용자 계정을 생성하라는 메시지가 표시됩니다.

ollama webui 관리자 계정 생성

세부 정보를 입력하고 '관리자 계정 생성'을 클릭하여 설정을 완료하세요.

성공입니다!

이제 모든 것이 정상적으로 작동하니, AI 모델을 불러오는 방법을 알아보겠습니다.

AI 모델 선택하기

Ollama를 사용하여 AI 모델을 직접 호스팅하는 가장 큰 장점은 DeepSeek , Gemma , Phi 등 다양한 버전의 도구를 선택할 수 있다는 점입니다 . 디스크 공간과 메모리만 충분하다면 원하는 만큼 여러 모델을 로드할 수 있습니다.

하지만 모델을 선택할 때 더 중요한 것은 매개변수의 크기입니다. 예를 들어, qwen3 : 7b 라고 표기된 AI 모델은 70억 개의 매개변수로 구축되었다는 의미입니다.

일반적으로 매개변수 크기는 몇 가지 정보를 알려줍니다.

- 인공지능 모델의 매개변수 크기가 클수록 모델이 더 복잡해집니다. 다시 말해, 더 나은 답변을 제공할 가능성이 높아집니다.

- 매개변수 크기가 큰 모델일수록 결과를 도출하는 데 시간이 더 오래 걸립니다.

- 매개변수 크기가 큰 모델일수록 로드하는 데 더 많은 RAM이 필요합니다.

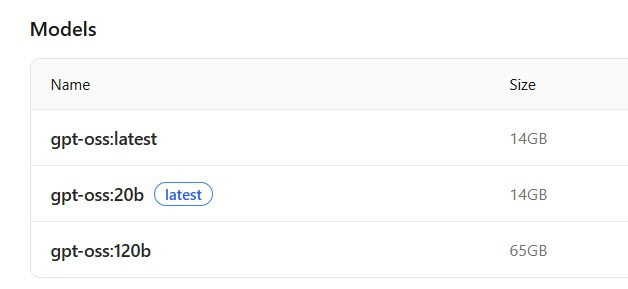

RAM 요구 사항이 있는 ollama chatgpt 모델

Ollama에서 사용 가능한 ChatGPT 모델과 해당 RAM 요구 사항입니다.

위 이미지에서 보시다시피, 현재 Ollama에서 사용 가능한 ChatGPT 모델은 20비트 와 120비트 입니다 . 120비트 모델은 65GB RAM을 필요로 하는데, 이는 라즈베리 파이에는 너무 높은 사양입니다. 16GB RAM이 장착된 라즈베리 파이 5를 사용한다면 20 비트 모델을 실행할 수 있습니다 .

RAM 용량이 충분하다면 라즈베리 파이에서 ChatGPT를 실행해 보세요. 하지만 아마 너무 느리게 느껴질 겁니다. 그래서 이 가이드에서는 라즈베리 파이에 더 적합한 모델들을 추천해 드리겠습니다.

Raspberry Pi 5의 경우 :

– 매개변수가 40억 개 이하인 모델부터 시작하는 것을 권장합니다. – gemma , qwen 또는 deepseek 과 같은 AI를 먼저 사용해 보세요 .

( 매개변수 크기, RAM 요구 사항 및 컨텍스트 창이 서로 다른 gemma3 모델)

Raspberry Pi 4의 경우 :

– 아주 작은 모델, 예를 들어 1b 파라미터 또는 그보다 더 작은 파라미터를 사용해 보세요. – 예를 들어 qwen:0.5b 또는 tinyllama:1.1b를 사용해 볼 수 있습니다 .

사용 가능한 모든 AI 모델과 해당 매개변수 크기를 확인하려면 Ollama 라이브러리를 살펴보세요 .

AI 모델 로딩

자, 이제 원하는 모델을 정하셨으니, 어떻게 하면 실제로 구할 수 있을까요?

웹 UI 인터페이스를 통해 Ollama에 AI 모델을 로드할 수 있습니다. 방법은 다음과 같습니다.

- Ollama 라이브러리 에서 로드하려는 모델의 이름을 복사합니다. 이 예에서는 gemma3:4b를 사용하겠습니다 .

- Ollama 웹 인터페이스에서 상단의 "모델 선택"을 클릭합니다. 검색 상자에 모델 이름을 붙여넣습니다.

올라마 웹UI 풀 모델

- 다운로드를 의미하는 '풀' 옵션을 클릭하세요 .

다운로드가 완료되면 상단의 드롭다운 메뉴를 사용하여 불러올 모델을 선택할 수 있습니다.

AI 모델과 대화하기

이후부터는 ChatGPT를 사용하는 방식과 동일합니다. 질문을 입력하고 Enter 키를 누른 다음 응답을 기다리면 됩니다 .

응답 속도는 클라우드 기반 AI에서 기대하는 것보다 느리겠지만, 그 대신 질문 수 제한이 없고, 사용자 추적이 없으며, 인터넷 연결이 필요 없다는 장점을 누릴 수 있습니다.

저는 라즈베리 파이 5 8GB에 70억 개의 매개변수를 가진 모델을 로드할 수 있었지만, 결과는 더 정확했지만 속도가 너무 느려서 만족스럽지 않았습니다.

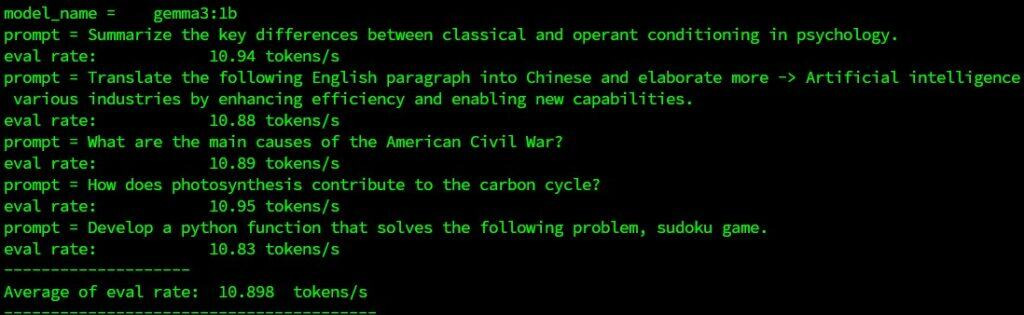

제가 너무 성급한 걸까요? 그래서 파라미터 개수를 줄여봤더니 qwen:0.5b 와 gemma3:1b가 제 시스템에서 훨씬 더 빠르게 반응했습니다.

답변 하단에 있는 정보 아이콘에 마우스를 올리면 해당 모델이 특정 질문에 대해 얼마나 잘 응답했는지 대략적인 정보를 확인할 수 있습니다.

하지만 이는 단지 시작일 뿐이며, 앞으로 성능이 향상될 수도 있습니다.

더 나아가기

이 정도면 시작하는 데 도움이 되었으면 좋겠습니다. 더 자세히 알아보고 싶으시다면, 다음과 같은 몇 가지 다른 기능들을 활용해 보세요.

특수 기능을 갖춘 AI 모델을 설치해 보세요 . 코딩(예: phi3 ), 이미지 인식(예: LLaVA ), 또는 롤플레잉(예: nemotron-mini ) 에 특화된 모델을 사용해 볼 수 있습니다 .

AI 모델 비교를 위한 벤치마크 - ollama-benchmark 와 같은 벤치마크 도구를 설치하여 하드웨어 및 사용 사례에 가장 적합한 모델을 확인하세요.

(일반적으로 초당 토큰 처리량 벤치마크가 높을수록 성능이 우수함을 의미합니다.)

성능 최적화 – 목적에 가장 적합한 모델을 선택했다면, 해당 모델의 다양한 설정을 조정하고 라즈베리 파이 하드웨어에 최적화하는 방법을 알아보세요. 일부 설정은 '제어' 메뉴에서 찾을 수 있으며, 고급 설정은 터미널 명령어를 통해 입력해야 할 수도 있습니다.

맞춤형 애플리케이션 – 원하는 작업에 딱 맞는 모델을 찾았다면, 직접 설계한 맞춤형 프로그램과 함께 AI를 활용할 수 있습니다. 예를 들어, 플레이어 입력에 반응하는 AI 기반 파이썬 게임을 만들 거나, 특정 상황에 따라 반응하는 로봇의 두뇌 역할을 AI에 맡길 수 있습니다 .

이제 라즈베리 파이에서 AI 모델을 실행할 수 있게 되었으니, 멋진 프로젝트를 만들기 위해 필요한 것은 여러분의 창의력을 발휘하는 것뿐입니다. 결국, 인공지능이 작동하려면 여러분 스스로 지능적인 부분을 채워줘야 할 테니까요.

라즈베리파이 팁: 튜토리얼 원문 참고자료

'라즈베리파이 5' 카테고리의 다른 글

| 라즈베리파이 클러스터, Kubernetes 사용하기 (0) | 2026.01.19 |

|---|---|

| 구형 라즈베리파이에 OS를 설치하는 방법 (0) | 2026.01.15 |

| 라즈베리 파이 4 모델 B를 이용한 비디오 계속 재생기 만들기 비디오 루퍼 (0) | 2026.01.15 |

| 라즈베리파이와 클라우드플레어 터널을 이용한 호스팅 (1) | 2026.01.12 |

| 라즈베리 파이 라우터 구현 OpenWrt 설치하기 (1) | 2026.01.10 |

| Raspberry Pi OS의 Cloud-init (0) | 2025.12.02 |

| Raspberry Pi 6에 관한 출시일, 사양 및 소문 (1) | 2025.11.25 |

| 10x faster pi in 3 simple step (0) | 2025.11.20 |

취업, 창업의 막막함, 외주 관리, 제품 부재!

당신의 고민은 무엇입니까? 현실과 동떨어진 교육, 실패만 반복하는 외주 계약,

아이디어는 있지만 구현할 기술이 없는 막막함.

우리는 알고 있습니다. 문제의 원인은 '명확한 학습, 실전 경험과 신뢰할 수 있는 기술력의 부재'에서 시작됩니다.

이제 고민을 멈추고, 캐어랩을 만나세요!

코딩(펌웨어), 전자부품과 디지털 회로설계, PCB 설계 제작, 고객(시장/수출) 발굴과 마케팅 전략으로 당신을 지원합니다.

제품 설계의 고수는 성공이 만든 게 아니라 실패가 만듭니다. 아이디어를 양산 가능한 제품으로!

귀사의 제품을 만드세요. 교육과 개발 실적으로 신뢰할 수 있는 파트너를 확보하세요.

캐어랩