YOLO(You Only Look Once)는 지난 10년간 가장 영향력 있는 컴퓨터 비전 아키텍처 중 하나였으며, 최신 버전인 YOLO11은 실시간 객체 탐지를 새로운 차원으로 끌어올렸습니다. 고성능 GPU를 필요로 했던 이전 모델과 달리, YOLO11은 속도, 정확성, 그리고 배포 용이성의 균형을 맞추도록 설계되었습니다. 연구원, 아마추어 사용자, 그리고 제품 개발자에게 있어 이는 클라우드 서비스에 의존하지 않고도 엣지 컴퓨팅 장치 에서 고급 비전 작업을 실행할 수 있다는 것을 의미합니다.

하지만 문제는 다음과 같습니다. YOLO 모델 설치 방법에 대한 튜토리얼은 수없이 많지만, 거의 모든 튜토리얼이 하드웨어 선택 에 대해서는 자세히 다루지 않습니다. GitHub 저장소 복제, Python 환경 설정, 모델 변환에 대한 가이드는 많지만, 핵심적인 질문에 대한 답을 제시하는 가이드는 거의 없습니다.

- 어떤 마이크로컨트롤러 또는 프로세서를 사용해야 할까요?

- YOLO11에 가장 적합한 카메라 센서는 무엇인가요?

- PCB와 커넥터를 어떻게 설계해야 안정성을 확보할 수 있을까요?

이 글에서는 YOLO11 기반 엣지 비전 모듈을 제작하는 전 과정을 자세히 설명합니다. 메인 제어 칩 선택부터 PCB 조립, 카메라 모듈 선정, 실제 성능 테스트까지 모든 단계를 안내합니다. 가장 좋은 점은 무엇일까요 ? 바로 추천 부품으로 바로 연결되는 전체 BOM(자재 명세서)을 제공하여, 복잡한 검색 과정 없이 손쉽게 이 프로젝트를 재현할 수 있도록 도와드린다는 것입니다.

이 가이드를 마치면 어떤 하드웨어를 선택해야 하는지, 어떻게 조립해야 하는지, 그리고 어떤 성능을 기대할 수 있는지 정확히 알게 될 것입니다. 학습 목적으로 DIY AI 카메라를 제작하든, IoT 제품에 컴퓨터 비전을 통합하든, 이 단계별 가이드는 시행착오를 거쳐 몇 주씩 걸리는 작업을 줄여줄 것입니다.

핵심 하드웨어 선택 가이드

적절한 하드웨어를 선택하는 것은 모든 엣지 AI 프로젝트의 핵심입니다. 클라우드 기반 환경에서는 강력한 GPU를 마음껏 활용할 수 있지만, 엣지 디바이스는 제한된 처리 능력, 메모리, 전력 소비량 등의 제약 조건에 직면합니다 . YOLO11은 최적화되어 있지만, 원활한 실시간 추론을 위해서는 기본 하드웨어를 신중하게 고려해야 합니다.

이 장에서는 세 가지 중요한 측면을 다루겠습니다.

- 메인 제어 칩(MCU/MPU) – 프로젝트의 두뇌

- 카메라 센서 모듈 – 프로젝트의 핵심

- PCB와 커넥터 - 모든 것을 하나로 묶어주는 신경계

메인 제어 칩(MCU/MPU) 선택

엣지 디바이스에서 YOLO11을 실행할 때 가장 중요한 결정 사항은 메인 제어 칩을 선택하는 것입니다. 어떤 칩을 선택하느냐에 따라 시스템의 처리 능력, 메모리 대역폭, 에너지 효율성 및 연결 옵션이 결정됩니다 . 주요 후보들을 자세히 살펴보겠습니다.

ESP32-S3 : 비용 효율적인 전력 절약기

ESP32 -S3 는 IoT 및 임베디드 비전 애플리케이션에 널리 사용되는 칩입니다. 240MHz로 작동하는 듀얼 코어 Xtensa LX7 CPU를 탑재하고 있으며, 내장 AI 가속 명령어 와 외부 RAM 지원 기능을 갖추고 있습니다. 특히, ESP32-S3에는 NPU(신경 처리 장치)가 통합되어 있어 객체 감지 및 이미지 분류와 같은 AI 작업 성능을 크게 향상시켜 줍니다.

YOLO11, 특히 YOLO11n(나노) 변형 의 경우 ESP32-S3는 해상도를 낮춰(예: 320×240) 놀라울 정도로 높은 FPS로 실시간 추론을 제공할 수 있습니다. 또한 에너지 효율이 매우 뛰어나 최대 사용 시에도 1W 미만의 전력을 소모합니다. 따라서 배터리 구동형 AI 카메라 나 저비용 IoT 프로젝트 에 이상적입니다 .

➡ 추천 제품 : [ ESP32-S3-WROOM-1-N16R8 모듈 ] – 16MB 플래시 메모리와 8MB PSRAM을 탑재하여 가벼운 AI 워크로드 처리에 적합합니다.

라즈베리 파이 컴퓨트 모듈 4: 균형 잡힌 작업용 기기

더 강력한 성능이 필요하다면 라즈베리 파이 컴퓨트 모듈 4(CM4)가 좋은 선택입니다. 1.5GHz로 작동하는 쿼드 코어 Cortex-A72 CPU를 탑재하고 최대 8GB RAM , 고속 eMMC 스토리지, 그리고 여러 개의 고속 카메라 인터페이스(MIPI-CSI)를 지원합니다. 따라서 640x480 또는 720p와 같은 고해상도에서 YOLO11을 실행하는 데 매우 적합합니다 .

CM4는 성능과 유연성 사이에서 균형을 잘 맞춥니다 . ESP32와 달리 완전한 기능을 갖춘 Linux 배포판을 실행할 수 있어 익숙한 Python 라이브러리, TensorFlow Lite 및 ONNX 런타임을 사용할 수 있습니다. 따라서 YOLO11을 로봇 공학, 산업 검사 또는 스마트 감시 시스템 과 통합하려는 경우 CM4는 훌륭한 선택입니다 .

➡ 추천 제품 : [라즈베리 파이 컴퓨트 모듈 4] – 중간급 AI 엣지 애플리케이션에 이상적입니다. 비기너 가이드 동영상 참고

젯슨 나노: AI 플래그십 제품

성능이 매우 중요한 고급 프로젝트의 경우 NVIDIA Jetson Nano는 여전히 최고의 선택지 중 하나입니다. 128코어 Maxwell GPU , 쿼드코어 ARM Cortex-A57 CPU , 4GB RAM을 탑재하고 있어 , 고해상도에서 YOLO11 모델을 실행하고도 실시간 FPS를 유지할 수 있습니다 .

단점은 무엇일까요? ESP32 및 CM4에 비해 전력 소비량이 높고(5~10W 범위) 크기가 더 크다는 것입니다. 배터리 구동 환경에는 적합하지 않지만, 전원 공급에 제약이 없는 산업용 엣지 AI 애플리케이션 에서는 뛰어난 성능을 발휘합니다.

➡ 추천 제품 : [NVIDIA Jetson Nano 개발자 키트] – 까다로운 엣지 AI 작업에 최적화된 솔루션입니다.

카메라 센서 모듈 선택

카메라 센서는 YOLO11 엣지 비전 시스템의 눈 과 같습니다 . 아무리 강력한 프로세서를 사용하더라도 카메라 센서를 잘못 선택하면 프로젝트의 병목 현상이 발생할 수 있습니다. 카메라 모듈을 선택할 때는 다음 사항을 고려해야 합니다.

- 해상도 : 해상도가 높을수록 탐지 정확도는 향상되지만 계산 부하가 증가합니다.

- 프레임률(FPS) : 실시간 감지에 필수적입니다.

- 인터페이스 유형 : 메인 칩에 따라 DVP, MIPI-CSI 또는 USB/UVC를 사용할 수 있습니다.

- 렌즈 크기 및 시야각 : 적용 범위와 감지 영역을 결정합니다.

OV2640: 임베디드 클래식

OmniVision OV2640 은 ESP32 기반 프로젝트에 널리 사용되는 2MP 카메라 모듈 입니다 . 최대 1600×1200 해상도를 지원하며 DVP(디지털 비디오 포트) 인터페이스를 통해 임베디드 시스템에 간편하고 안정적으로 사용할 수 있습니다. 컴팩트한 크기, 저렴한 가격, 그리고 ESP32-S3와의 호환성 덕분 에 AI 엣지 프로젝트를 위한 최적의 입문용 카메라 입니다 .

➡ 추천 제품 : [OV2640 2MP 카메라 모듈] – 작고 저렴하며 설치가 간편합니다.

소니 IMX219: 고해상도, 고품질

더욱 선명한 화질이 필요하다면, 뛰어난 저조도 성능을 제공하고 MIPI-CSI 인터페이스를 지원하는 8MP 센서 인 Sony IMX219를 사용해 보세요. 이 카메라는 공식 Raspberry Pi 카메라 모듈에 사용되는 것과 동일한 카메라이므로 Raspberry Pi CM4 와 완벽하게 호환됩니다 .

OV2640보다 가격은 비싸지만, 더 높은 해상도에서 더 뛰어난 감지 정확도를 제공하므로 산업 검사, 자율 주행 차량 또는 로봇 비전 과 같은 응용 분야에 필수적인 요소입니다 .

➡ 추천 제품 : [소니 IMX219 카메라 모듈] – 라즈베리 파이 기반 YOLO11 설정에 최적의 선택입니다.

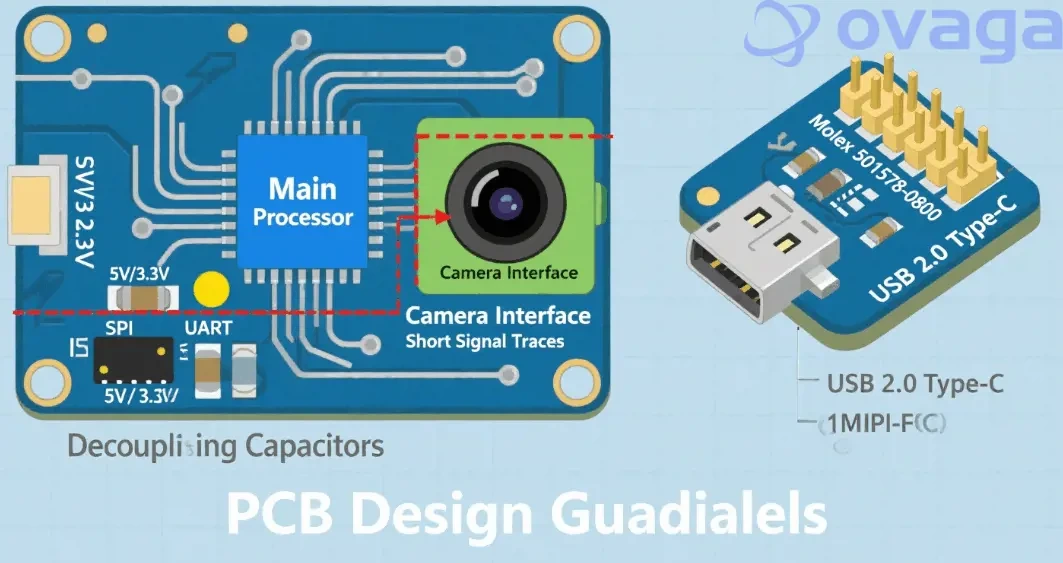

PCB 및 커넥터

아무리 최첨단 프로세서와 카메라 모듈을 사용하더라도 PCB 설계 와 커넥터가 불안정하면 소용이 없습니다. 견고한 PCB는 신호 무결성, 안정적인 전력 공급 및 장기적인 내구성을 보장합니다 .

PCB 설계 시 고려 사항

- 신호 안정성을 위해 카메라와 메인 MCU/MPU 사이의 배선을 짧게 유지하십시오 .

- 전압 안정화를 위해 전원 입력부 근처에 디커플링 커패시터를 설치하십시오 .

- UART, SPI 및 I2C 디버깅을 위한 테스트 패드를 추가합니다 .

프로토타입 제작 단계에서는 많은 개발자들이 핀 헤더가 있는 기성 개발 보드를 사용합니다 . 하지만 양산 단계로 넘어갈 때는 폼팩터를 줄이고 성능을 향상시키기 위해 맞춤형 PCB를 설계하는 것이 강력히 권장됩니다.

➡ 추천 서비스 : [ 맞춤형 PCB 프로토타입 제작 및 조립] – 거버 파일을 업로드하시면 신속하게 보드를 제작해 드립니다.

커넥터 선택

모듈형 테스트에는 2.54mm 핀 헤더와 암형 헤더가 부품 교체가 용이하여 매우 유용합니다. 하지만 최종 제품에는 진동이나 반복 사용 환경에서 안정성을 높이기 위해 표면 실장형 커넥터 또는 보드 간 커넥터가 더 적합합니다.

➡ 추천 제품 : [2.54mm 핀 헤더 및 소켓 세트] – 프로토타이핑 및 디버깅에 적합한 다용도 제품입니다.

소프트웨어 환경 설정 및 모델 배포

YOLO11 엣지 비전 프로젝트의 하드웨어 기반이 마련되었으니 , 다음 과제는 소프트웨어 환경을 준비 하는 것입니다 . 최적화된 소프트웨어가 없는 하드웨어는 연료 없는 스포츠카와 같습니다. 겉보기에는 멋지지만, 제대로 된 성능을 발휘할 수는 없습니다. 이 장에서는 다양한 플랫폼에 맞는 개발 환경 설정, YOLO11 모델 배포 준비, 그리고 펌웨어 플래싱이 원활하게 진행되도록 하는 방법을 살펴보겠습니다. 이 장을 마치면 선택한 엣지 디바이스에서 YOLO11 추론을 실행하는 데 필요한 모든 것을 갖추게 될 것입니다.

개발 환경

각기 다른 메인 제어 칩은 서로 다른 소프트웨어 스택을 필요로 합니다. 잘못된 설정을 선택하면 디버깅에 며칠을 허비할 수 있으므로, 어떤 환경이 어떤 하드웨어에 적합한지 명확히 해야 합니다.

ESP32-S3: 아두이노 또는 ESP-IDF

ESP32-S3의 경우 크게 두 가지 방법이 있습니다.

- 아두이노 IDE : 초보자에게 친숙하고 설정이 빠르며 프로토타입 제작에 적합합니다.

- ESP-IDF(Espressif IoT Development Framework) : 더 심층적인 하드웨어 접근, 고급 디버깅 및 향상된 최적화 제어 기능을 제공하는 공식 SDK입니다.

초보자라면 아두이노 가 빠르게 시작할 수 있는 방법이지만, NPU의 성능을 최대한 활용하고 싶다면 ESP-IDF가 적합합니다 . ESP-IDF를 사용하면 양자화 최적화를 통한 모델 추론을 지원하는 Espressif의 딥러닝 라이브러리인 ESP-DL을 직접 통합할 수도 있습니다 .

라즈베리 파이 CM4: 라즈베리 파이 OS

CM4의 경우 표준 Raspberry Pi OS(64비트)가 잘 작동합니다. 이 OS는 다음과 같은 Linux 환경을 제공합니다.

- 경량 YOLO11 모델 실행을 위한 TensorFlow Lite.

- 이식 가능한 모델 추론을 위한 ONNX 런타임.

- 이미지 전처리 및 시각화를 위한 OpenCV.

라즈베리 파이 생태계는 강력한 커뮤니티 지원을 바탕으로 카메라 스트리밍, 신경망 추론, GPIO 제어 등을 위한 기성 스크립트와 예제를 쉽게 찾을 수 있도록 해줍니다.

젯슨 나노: JetPack SDK

Jetson Nano를 사용하려면 NVIDIA JetPack SDK가 필요합니다 . JetPack SDK는 기본적으로 GPU 가속 지원 기능이 추가된 Ubuntu입니다. JetPack을 사용하면 다음과 같은 기능을 활용할 수 있습니다.

- GPU 가속 연산을 위한 CUDA 및 cuDNN.

- 모델 최적화를 위해 TensorRT를 사용하세요(추론 속도를 두 배로 높일 수 있습니다).

- 고급 비디오 분석을 위한 DeepStream SDK .

젯슨 나노는 단연코 가장 강력한 플랫폼이지만, 학습 곡선 또한 가장 가파릅니다. 고성능이 필요하고 초기 설정에 투자할 의향이 있다면 충분히 가치가 있습니다.

모델 변환 및 최적화

초보자들이 저지르는 가장 큰 실수 중 하나는 YOLO11 PyTorch 모델을 엣지 디바이스에서 그대로 실행하려고 하는 것입니다. ESP32나 라즈베리 파이 같은 엣지 칩은 이러한 대규모 모델을 직접 처리할 수 없으며, 변환 및 최적화 과정 이 필요합니다 .

1단계: PyTorch에서 YOLO11을 내보내기

YOLO11 모델은 일반적으로 PyTorch로 학습됩니다. 첫 번째 단계는 서로 다른 런타임 간의 범용 브리지 역할을 하는 ONNX 형식 으로 모델을 내보내는 것입니다.

python export.py --weights yolov11n.pt --include onnx

다음은 저전력 기기에 가장 적합한 YOLO11의 나노yolov11n.pt 버전 입니다 .

2단계: TensorFlow Lite로 변환

Raspberry Pi와 ESP32-S3의 경우 ONNX를 TensorFlow Lite로 변환하는 것이 필수적입니다. TensorFlow Lite 모델은 크기가 작고 엣지 추론에 최적화되어 있습니다.

onnx-tf convert -i yolov11n.onnx -o yolov11n.tflite

3단계: 양자화 적용

양자화는 FP32 대신 INT8 또는 FP16 정밀도를 사용하여 모델 크기를 줄이고 추론 속도를 향상시킵니다 . ESP32-S3에서는 실시간 성능을 위해 양자화가 필수적입니다.

converter = tf.lite.TFLiteConverter.from_saved_model("yolov11n")

converter.optimizations = [tf.lite.Optimize.DEFAULT]

tflite_quant_model = converter.convert()

이를 통해 모델 크기를 4배 , 추론 지연 시간을 2배 이상 줄일 수 있으며, 정확도는 약간만 저하됩니다.

4단계: 배포

ESP32-S3 : 양자화된 TFLite 모델을 플래시/PSRAM에 저장하고 ESP-DL API를 통해 호출합니다.

Raspberry Pi : Python에서 TFLite 모델을 로드하려면 다음을 사용합니다 tflite_runtime.

Jetson Nano : TensorRT를 사용하여 ONNX를 최적화된 엔진 파일로 변환하여 최대 FPS를 구현하세요.

펌웨어 플래싱 도구

모델을 작동시키려면 먼저 펌웨어와 바이너리 파일을 기기에 플래싱 하는 방법이 필요합니다 . 이때 USB-TTL 다운로더가 사용됩니다.

USB-TTL이 필수적인 이유

- ESP32-S3는 USB가 내장된 공식 개발 보드를 사용하지 않는 한 프로그래밍할 수 없습니다.

- 또한 모델이 실행되는 동안 ESP32에서 로그를 읽어 직렬 디버깅 에 유용합니다 .

- 라즈베리 파이와 젯슨 나노의 경우, USB-TTL은 특히 HDMI 없이 작업할 때 UART 콘솔 디버깅 에 도움이 됩니다.

➡ 추천 제품 : [USB-TTL 다운로더 모듈] – 가볍고 안정적이며 펌웨어 플래싱에 필수적인 제품입니다.

어셈블리, 디버깅 및 성능 테스트

이제 진짜 재미있는 부분, 바로 모든 부품을 조립하는 단계가 남았습니다. 올바른 부품과 소프트웨어가 있더라도 조립과 디버깅 과정 에서 YOLO11 비전 모듈의 성공 여부가 결정될 수 있습니다. 이 장에서는 배선, 흔히 발생하는 문제점, 그리고 무엇보다 중요한 실제 성능 벤치마크에 대해 다룹니다 .

하드웨어 조립 가이드

이를 세 가지 핵심 단계 로 나누어 보겠습니다 .

1. MCU/MPU를 마운트합니다.

- ESP32-S3를 사용하는 경우, 브레이크아웃 보드 또는 맞춤형 PCB에 납땜하십시오.

- Raspberry Pi CM4의 경우 MIPI-CSI 슬롯이 있는 캐리어 보드에 장착하십시오.

- Jetson Nano는 개발자 키트와 함께 바로 사용할 수 있습니다.

2. 카메라를 연결하세요

- OV2640과 ESP32-S3의 연결: DVP 인터페이스 핀(VSYNC, HREF, PCLK 등)을 통해 연결합니다.

- CM4가 포함된 IMX219 : 평면 MIPI-CSI 리본 케이블을 통해 연결합니다.

- Jetson Nano를 이용한 USB 카메라 : 연결만 하면 바로 사용 가능

3. 전원 및 디버그

- 라즈베리 파이와 젯슨 나노에는 안정적인 5V 전원을 사용하십시오 .

- ESP32-S3의 경우 3.3V 입력이면 충분합니다.

- 실시간 로깅을 위해 USB-TTL 디버거를 연결해 두십시오.

꿀팁: YOLO11을 로드하기 전에 항상 더미 스크립트 (예: 카메라 영상 표시)로 테스트하세요. 이렇게 하면 하드웨어 문제와 소프트웨어 버그를 구분할 수 있습니다.

디버깅 프로세스

어떤 프로젝트도 처음부터 완벽하게 진행되지는 않습니다. 다음은 가장 흔한 문제점과 해결 방법입니다.

- 카메라가 감지되지 않았습니다 . 리본 케이블 방향을 확인하십시오(MIPI-CSI에서 흔히 발생하는 오류입니다).

- Jetson Nano 과열 문제 : 방열판과 팬을 추가하세요. YOLO11 추론은 GPU에 상당한 부하를 줍니다.

- ESP32-S3 메모리 부족 오류 : 양자화된 YOLO11n 모델과 외부 PSRAM 모듈을 사용하고 있는지 확인하십시오.

- 무작위 재부팅 : 전원 불안정으로 인해 발생하는 경우가 많습니다. 콘덴서를 사용하거나 더 강력한 전원 공급 장치를 사용하십시오.

디버깅은 짜증나는 일이지만, 문제를 해결할 때마다 임베디드 AI 시스템이 실제 환경에서 어떻게 작동하는지 배우게 됩니다.

성능 벤치마킹

마지막으로 중요한 수치를 살펴보겠습니다. 최적화된 모델을 사용하여 각 플랫폼에 YOLO11을 배포했을 때 기대할 수 있는 결과는 다음과 같습니다.

| Platform | Model Variant | Resolution | FPS | Power Consumption |

| ESP32-S3-룸-1 | YOLO11n (양자) | 320×240 | 약 15 FPS | <1W |

| 라즈베리 파이 CM4 | YOLO11n (TFLite) | 640×480 | 약 20 FPS | 약 5와트 |

| 젯슨 나노 | YOLO11 (TensorRT) | 1280×720 | 약 30 FPS | 5~10W |

이러한 벤치마크 결과는 ESP32-S3가 저전력 애플리케이션에 적합하고 , CM4는 성능과 효율성의 균형을 잘 맞추며 , Jetson Nano는 고해상도 실시간 감지에 탁월함을 보여줍니다 .

➡ 이것이 바로 사용자들이 구매를 결정하게 만드는 데이터입니다: 실제 검증된 결과.

응용 프로그램, 확장 기능 및 향후 업그레이드

지금까지 하드웨어 선택, 소프트웨어 설정, 시스템 조립, 심지어 성능 벤치마킹까지 살펴보았습니다. 하지만 YOLO11 기반 엣지 비전 모듈의 진정한 매력은 바로 활용 가능성에 있습니다 . 취미 활동가, 스타트업 창업자, 산업 엔지니어 등 누구든 이 플랫폼을 다양한 실제 응용 분야에 적용할 수 있습니다. 이 장에서는 가장 실용적인 몇 가지 활용 사례를 살펴보고, 업그레이드 옵션을 논의하며, 단순한 프로토타입 단계를 넘어 프로젝트를 확장하는 로드맵을 제시합니다.

실제 사용 사례

YOLO11은 일반 메이커와 엔지니어들이 실시간 객체 감지 기능을 활용할 수 있도록 지원합니다. 다음은 당사의 엣지 컴퓨팅 비전 모듈이 빛을 발할 수 있는 몇 가지 시나리오입니다.

스마트 감시

기존 CCTV 시스템은 수동적입니다. 영상을 녹화만 할 뿐 실시간으로 분석할 수는 없습니다. YOLO11을 ESP32-S3 또는 Raspberry Pi CM4 와 통합하면 영상 촬영뿐 아니라 침입자 감지, 인원 계수, 움직임 추적 까지 즉시 가능한 스마트 감시 카메라를 구축할 수 있습니다 .

예를 들어, 매장 주인은 입구에 라즈베리 파이 기반 카메라를 설치하여 방문객 수를 세거나 의심스러운 행동을 감지할 수 있습니다. 클라우드 기반 AI 서비스와 달리, 이러한 방식은 오프라인에서 실행되므로 개인 정보 보호와 낮은 지연 시간을 보장합니다 .

산업 검사

공장들은 품질 관리를 위해 컴퓨터 비전 에 점점 더 의존하고 있습니다 . 부품을 운반하는 컨베이어 벨트를 상상해 보세요. YOLO11 모듈은 실시간으로 불량 부품을 식별하고 로봇 팔을 작동시켜 해당 부품을 제거할 수 있습니다. Jetson Nano에서 이 시스템은 초당 30프레임의 높은 정확도로 미세한 불규칙성까지 감지할 수 있습니다.

로봇공학 및 드론

자율 로봇과 드론은 주변 환경을 탐색하고 상호 작용하기 위해 시각 정보가 필요합니다. CM4 또는 Jetson Nano에서 YOLO11을 실행하면 로봇은 장애물을 감지하고, 사람을 추적하거나, 물체의 위치를 파악할 수 있습니다 . 드론의 경우, 경량 ESP32-S3와 OV2640을 사용하면 비행 배터리를 소모하지 않고 기본적인 물체 추적 기능을 제공할 수 있습니다.

DIY AI 카메라 프로젝트

취미 생활을 즐기는 사람들에게는 무궁무진한 가능성이 열려 있습니다. 반려견이 소파에 올라왔을 때 알림을 보내주는 반려동물 모니터링 카메라를 만들어보고 싶으신가요? 아니면 방에 들어오면 조명이 자동으로 켜지는 스마트 홈 시스템을 만들어보고 싶으신가요? YOLO11은 이러한 DIY 프로젝트를 재미있고 실용적으로 만들어줍니다.

가능한 확장 기능

기본 설정을 숙지한 후에는 YOLO11 엣지 비전 모듈에 추가 기능을 더하여 더욱 강력하고 다재다능하게 만들 수 있습니다.

4G/LTE 연결

무선 연결 기능을 추가하면 AI 카메라가 원격 서버로 알림을 보내거나, 이미지를 업로드하거나, 감지된 정보를 스트리밍할 수 있습니다. 이를 위해 Ai-Thinker A7670C 4G CAT1 모듈을 권장합니다 . 이 모듈은 UART/USB를 통해 간편하게 통합되며 데이터 및 SMS 통신을 모두 지원합니다.

➡ 추천 제품 : [Ai-Thinker A7670C 4G 모듈] – 원격 접속이 필요한 IoT 비전 프로젝트에 적합합니다.

휴대성을 위한 배터리 전원

AI 카메라를 야외에서 사용하고 싶으신가요? 5000mAh 3.7V 리튬 이온 배터리 와 충방전 관리 모듈을 통해 현장에서도 비전 시스템을 활용할 수 있습니다. ESP32-S3는 1W 미만의 저전력 소비 덕분에 한 번 충전으로 수 시간 동안 사용할 수 있습니다 .

➡ 추천 제품 : [5000mAh 리튬 이온 배터리 팩] – 컴팩트하고 오래 지속됩니다.

➡ 추천 제품 : [배터리 충전 및 전력 관리 모듈] – 안전한 작동과 수명 연장을 보장합니다.

3D 프린팅 케이스

점퍼선에 매달린 PCB와 카메라는 테스트에는 괜찮지만 실제 배포에는 적합하지 않습니다. 3D 프린팅 케이스를 설계하면 내구성, 먼지 방지 및 전문적인 외관을 확보할 수 있습니다. 삼각대나 벽걸이 마운트를 추가하여 모듈을 바로 설치할 수 있도록 만들 수도 있습니다.

센서 융합

시각 정보만으로도 강력하지만, YOLO11을 다른 센서와 결합하면 새로운 가능성이 열립니다. 추가:

- 하이브리드 감지를 위한 PIR 모션 센서 .

- 거리를 측정하는 초음파 센서 .

- 스마트 농업 프로젝트를 위한 환경 센서 .

이렇게 하면 비전 모듈이 단순한 독립형 AI 카메라가 아닌, 완벽한 스마트 시스템 의 일부가 됩니다.

최종 행동 촉구

지금까지 여러분은 적절한 하드웨어 선택부터 YOLO11 모델 실행, 최적화, 성능 테스트, 그리고 최종적으로 응용 분야 탐색에 이르기까지 전체 과정을 살펴보았습니다. 다음 단계는 무엇일까요?

이제 직접 만들어볼 시간입니다 .

각 부품을 개별적으로 찾아다니는 대신, 모든 구성품이 포함된 패키지를 간편하게 구매하실 수 있습니다 . ESP32-S3부터 OV2640 카메라, 헤더, 커넥터까지 모든 부품은 호환성을 보장하기 위해 신중하게 선택하고 테스트되었습니다.

➡ 여기를 클릭하여 전체 BOM 키트를 다운로드하고 지금 바로 YOLO11 기반 엣지 비전 모듈 제작을 시작하세요!

결론

YOLO11 기반 엣지 컴퓨팅 비전 모듈 구축은 처음에는 다소 어렵게 느껴질 수 있지만, 하드웨어, 소프트웨어, 조립 및 최적화 단계로 나누어 생각하면 학생부터 전문가까지 누구나 충분히 해낼 수 있는 프로젝트가 됩니다.

이 가이드를 통해 우리가 함께 이뤄낸 성과는 다음과 같습니다.

- 다양한 성능 수준에 맞는 MCU/MPU (ESP32-S3, CM4, Jetson Nano)를 선택 하는 방법을 배웠습니다 .

- 해상도, 인터페이스 및 애플리케이션 요구 사항에 따라 카메라 모듈 (OV2640, IMX219)을 선택했습니다 .

- PCB 설계 및 커넥터 관련 모범 사례를 이해하여 안정적인 제품 생산이 가능합니다.

- 소프트웨어 환경을 설정하고 , YOLO11 모델을 변환한 후 최적화를 적용했습니다.

- 모듈을 조립하고, 일반적인 문제를 디버깅하고, 실제 성능을 테스트했습니다 .

- 감시, 로봇 공학, 4G 모듈, 배터리 및 3D 프린팅 케이스와 같은 응용 분야 및 확장 가능성을 탐구했습니다 .

결과적으로, 거의 모든 사용 사례에 적용할 수 있는 유연하고 저렴하며 고성능의 AI 비전 시스템이 탄생합니다 .

인공지능 기반 감시 카메라를 구축하든, 스마트 로봇 비전 시스템을 만들든, 아니면 임베디드 AI를 직접 다뤄보든, 이 가이드는 오늘 바로 시작하는 데 필요한 지식과 도구를 제공합니다 .

자, 이제 여러분만의 YOLO11 엣지 비전 모듈을 제작 하고 프로젝트를 한 단계 더 발전시킬 준비가 되셨나요 ?

'STM32' 카테고리의 다른 글

| STM32 및 몽구스 웹 서버 파트 2: 구성 및 핑 테스트 (0) | 2026.02.02 |

|---|---|

| Modbus 센서 에뮬레이션 2부: 통신 설정 (0) | 2026.01.19 |

| STM32H7 듀얼 코어 시작하기: 펌웨어 플래싱 방법 (2) | 2025.12.18 |

| STM32: MAX485 모듈을 사용한 RS485 통신 (0) | 2025.11.17 |

| stm32cube에서 코드 작성 방법 (0) | 2025.10.29 |

| stm32cube와 ST-Link V2 연결 케이블 (0) | 2025.10.29 |

| STM32 U8G2 그래픽 라이브러리 사용하는 방법 (0) | 2025.09.14 |

| STM32 MAX485 사용한 RS485 통신 (3) | 2025.08.27 |

취업, 창업의 막막함, 외주 관리, 제품 부재!

당신의 고민은 무엇입니까? 현실과 동떨어진 교육, 실패만 반복하는 외주 계약,

아이디어는 있지만 구현할 기술이 없는 막막함.

우리는 알고 있습니다. 문제의 원인은 '명확한 학습, 실전 경험과 신뢰할 수 있는 기술력의 부재'에서 시작됩니다.

이제 고민을 멈추고, 캐어랩을 만나세요!

코딩(펌웨어), 전자부품과 디지털 회로설계, PCB 설계 제작, 고객(시장/수출) 발굴과 마케팅 전략으로 당신을 지원합니다.

제품 설계의 고수는 성공이 만든 게 아니라 실패가 만듭니다. 아이디어를 양산 가능한 제품으로!

귀사의 제품을 만드세요. 교육과 개발 실적으로 신뢰할 수 있는 파트너를 확보하세요.

캐어랩