애플은 UI를 이해하는 MLLM(Multimodal Large Language Model)인 Ferret-UI라는 모델에 대한 논문을 공개했습니다.

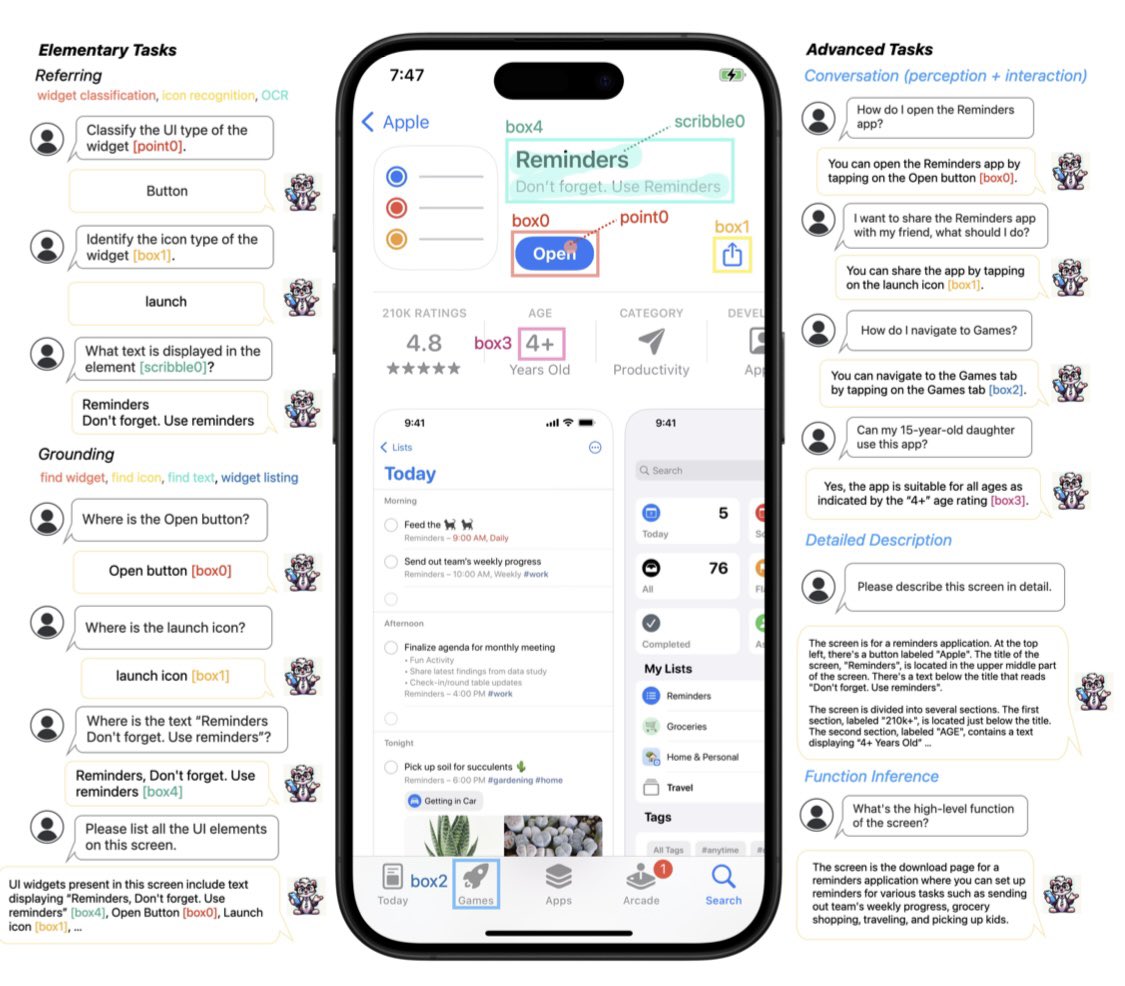

이 모델은 모바일 UI 화면을 이해하고, 사용자 지시에 따라 다양한 열린(특정한 작업에 한정되지 않은) 작업을 수행하는 모델입니다.

GPT-4V 같은 기존의 이미지를 인식하는 MLLM의 경우, 앱 상의 요소들을 인식하는 능력은 다소 떨어지는데요. 이 성능을 높이기 위한 연구입니다.

- 아이콘 인식: 화면 상의 아이콘을 식별

- 텍스트 찾기: 인터페이스의 텍스트 인식

- 위젯 나열: 화면에서 사용 가능한 위젯 나열

- 자세한 설명: 보고있는 화면을 설명

- 인식/상호 작용 대화: 화면에 대한 인식을 바탕으로 대화 형태의 상호작용을 수행

애플의 최근 논문들은 역시 인터페이스, 사용자 경험의 애플답게, 대부분 사용자의 디바이스에서 인터페이스를 이해하는 기능을 하는 연구들인데요.

이러한 연구들을 잘 살펴보면 애플이 준비하고 있는 AI가 어떤 것인지 약간의 힌트를 알 수 있지 않을까합니다. (공간 컴퓨팅 내에서 음성으로 객체들을 인식하고 다루기, 애플 숏컷 기능을 이용해 앱 자동화하기 등)

논문 주소 링크: Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs

'개발자 > 인공지능과 인간' 카테고리의 다른 글

| 로봇의 종류 (0) | 2024.04.24 |

|---|---|

| 물질을 설계하고 만들기 위해 로봇을 제어할 수 있을까요? (0) | 2024.04.22 |

| 언어 모델용 합성 데이터에 대한 모범 사례 및 교훈 (2) | 2024.04.12 |

| 데이터 과학 교육은 대규모 언어 모델로 무엇을 해야 할까요? (0) | 2024.04.11 |

| 인공 지능과 인공 일반 지능의 차이점은 무엇인가요? (0) | 2024.03.26 |

| ChatGPT가 지은 한시를 감상 (1) | 2024.03.14 |

| 일리야 수츠케버, AGI 이후의 미래에 대하여 (1) | 2024.03.12 |

| 스탠퍼드 과학자들이 발견한 사실, ChatGPT가 점점 더 멍청해지고 있습니다 (1) | 2023.08.08 |

취업, 창업의 막막함, 외주 관리, 제품 부재!

당신의 고민은 무엇입니까? 현실과 동떨어진 교육, 실패만 반복하는 외주 계약,

아이디어는 있지만 구현할 기술이 없는 막막함.

우리는 알고 있습니다. 문제의 원인은 '명확한 학습, 실전 경험과 신뢰할 수 있는 기술력의 부재'에서 시작됩니다.

이제 고민을 멈추고, 캐어랩을 만나세요!

코딩(펌웨어), 전자부품과 디지털 회로설계, PCB 설계 제작, 고객(시장/수출) 발굴과 마케팅 전략으로 당신을 지원합니다.

제품 설계의 고수는 성공이 만든 게 아니라 실패가 만듭니다. 아이디어를 양산 가능한 제품으로!

귀사의 제품을 만드세요. 교육과 개발 실적으로 신뢰할 수 있는 파트너를 확보하세요.

캐어랩